Você já parou pra pensar no impacto que modelos de linguagem com código aberto podem ter no seu negócio?

Ter mais controle, reduzir custos com infraestrutura, escalar soluções de IA… Algum desses objetivos faz sentido pra você?

É muito provável que sim, afinal, aqui no Brasil e no mundo, cada vez mais empresas e desenvolvedores estão buscando autonomia, flexibilidade e eficiência na hora de implementar inteligência artificial no dia a dia.

Recentemente, vi um movimento bem interessante ganhando força: o lançamento dos modelos gpt-oss-120b e gpt-oss-20b, que trazem desempenho de ponta em tarefas de raciocínio — com peso aberto e licença super flexível (Apache 2.0). O que mais chamou minha atenção? Eles funcionam até em máquinas mais simples, com 16 GB de memória, e entregam resultados no nível dos modelos comerciais mais avançados.

Se você quer entender como isso pode mudar o jogo, precisa conferir esse artigo. Você vai saber mais sobre:

- as diferenças entre os modelos gpt-oss-120b e gpt-oss-20b

- quais benchmarks eles superaram (inclusive modelos pagos)

- como funciona a arquitetura e o processo de treinamento

- aplicações práticas e casos de uso reais

- como baixar, usar e até personalizar esses modelos

Ou seja, depois dessa leitura, você vai saber de forma clara e simples se vale a pena apostar nesses modelos abertos no seu projeto de IA.

O que são os modelos gpt-oss?

Esses dois modelos são o novo passo da OpenAI na direção da IA aberta. Sim, isso mesmo… depois de muito tempo trabalhando só com versões fechadas, agora eles disponibilizaram o gpt-oss-120b e o gpt-oss-20b com pesos abertos e performance impressionante.

O gpt-oss-120b, por exemplo, bate de frente com o o4-mini (modelo pago da própria OpenAI) em tarefas de raciocínio complexo. E tudo isso rodando em uma GPU de 80 GB. Já o irmão menor, o gpt-oss-20b, funciona até em notebooks mais robustos com 16 GB — ótimo pra quem precisa rodar IA localmente, sem depender de servidores externos.

Esses modelos são bons mesmo?

Pra ser direto: sim, são muito bons. Eles foram testados em benchmarks de alto nível, como:

- Codeforces (programação competitiva)

- HealthBench (conversas médicas realistas)

- AIME 2024 e 2025 (matemática avançada)

- MMLU (diversas disciplinas acadêmicas)

E os resultados? Em muitos casos, melhores que o o3-mini e até o o4-mini, que são modelos pagos da própria OpenAI.

Por exemplo: no AIME 2024, o gpt-oss-20b chegou a 98,7% de acerto. Isso é nível de elite.

Como esses modelos funcionam por dentro?

Pra quem gosta da parte mais técnica (eu gosto, confesso kkk), os dois modelos usam arquitetura Transformer com o famoso Mixture of Experts (MoE). Isso ajuda a reduzir o custo computacional, ativando só parte dos parâmetros por token.

- gpt-oss-120b tem 117 bilhões de parâmetros, mas só ativa 5,1 bilhões por token

- gpt-oss-20b tem 21 bilhões, com 3,6 bilhões ativos por token

Além disso, suportam contexto de até 128 mil tokens. Dá pra trabalhar com textos e históricos bem longos.

Ah, e eles foram treinados com dados em inglês, focando bastante em áreas como ciência, tecnologia e programação. Um prato cheio pra quem precisa de raciocínio técnico.

E a parte de segurança?

Aqui tem um ponto que merece destaque. A OpenAI não lançou esses modelos de qualquer jeito. Eles passaram por:

- Treinamentos específicos de segurança

- Avaliações de resistência a ataques adversariais

- Testes com especialistas independentes

Inclusive, testaram versões maliciosas do modelo (simulando o que hackers fariam) pra garantir que mesmo com ajustes, os modelos não se tornariam perigosos. Isso é raro de ver no mercado de IA aberta.

Como usar esses modelos no seu projeto?

Eles estão disponíveis gratuitamente no Hugging Face, prontos pra rodar com quantização otimizada (MXFP4). Isso significa que:

- O gpt-oss-120b roda com 80 GB de memória

- O gpt-oss-20b precisa de apenas 16 GB

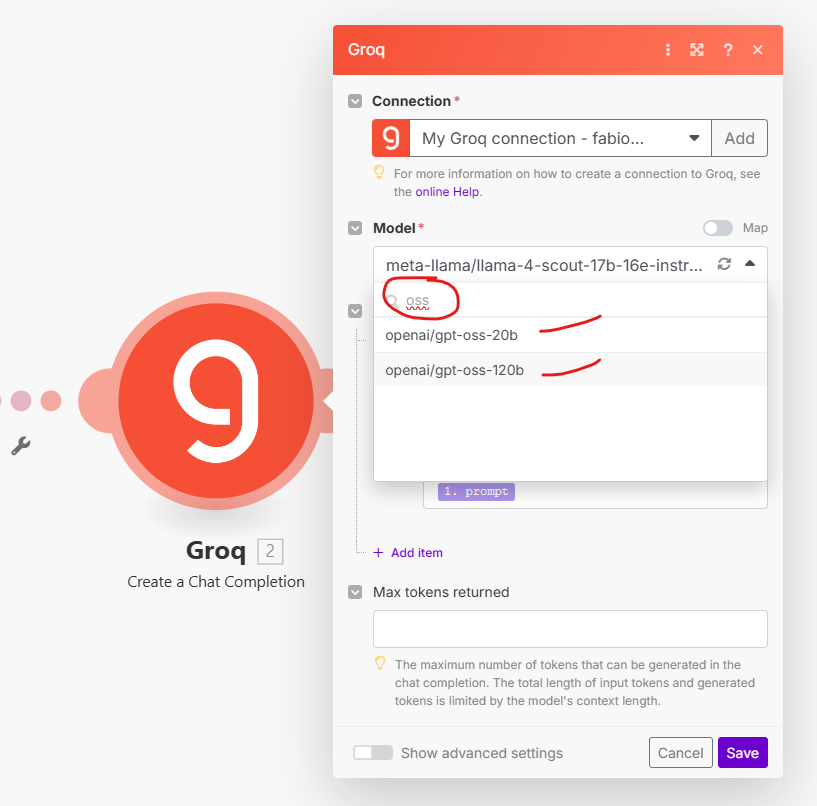

E tem mais: ambos os modelos já estão disponíveis para uso direto dentro do GROQ, uma plataforma que vem ganhando espaço com inferência ultrarrápida. Ou seja, você nem precisa se preocupar com a infraestrutura, é só começar a usar.

A OpenAI também liberou ferramentas de suporte, como:

- renderizador em Python e Rust

- scripts de inferência com PyTorch

- exemplos práticos de uso com código

E o melhor: estão integrados com plataformas como Azure, AWS, Vercel, Cloudflare e até o VS Code da Microsoft.

Quando usar o modelo de 20B e quando usar o de 120B?

Essa é uma dúvida comum. A resposta tá no tipo de tarefa que você vai executar:

- Use o gpt-oss-20b em tarefas simples, como geração de texto básica, extração de informações ou automações rápidas

- Já o gpt-oss-120b é mais indicado quando você precisa de raciocínio mais intenso ou análise mais profunda

É como escolher entre um carro popular e um SUV 4×4. Cada um tem seu momento.

Pra fechar com chave de ouro…

Os modelos gpt-oss mostram que é possível ter desempenho de altíssimo nível com flexibilidade total. São ferramentas pra quem quer construir soluções reais com IA, sem depender de infra cara ou de terceiros.

Se você ainda não testou, eu recomendo começar com o gpt-oss-20b. Leve, eficiente e pronto pra rodar até no seu notebook mais parrudo. Se o seu projeto pedir mais força, aí sim vale mergulhar no 120b.

E se você quiser se aprofundar no uso desses modelos com segurança, aplicabilidade e visão de negócio, o melhor caminho é estar por dentro da Comunidade IA na Prática. Lá eu compartilho dicas, tutoriais e aprendizados do nosso treinamento completo. É o lugar certo pra quem quer aprender IA do zero até a aplicação real, com orientação e apoio.

Um abraço e até a próxima!